Microbios, macrodatos, onda gravitatorias, la partícula de Higgs y la interfaz cerebro-computadora: estos son solo algunos de los descubrimientos que dejaron huella en una década de revoluciones científicas que cambiarán nuestras vidas, y que ya las están cambiando.

El futuro ya está aquí: computadoras cuánticas

La primera década de este siglo culminó con la publicación de lo que fue descrito como la primera computadora cuántica completa, que utiliza unidades de información cuántica, llamadas cúbits. A diferencia de una computadora normal, en la que el valor de un bit es 0 o 1, el cúbit de una computadora cuántica puede mostrar ambos al mismo tiempo o combinaciones de estos valores, lo que aumenta considerablemente la capacidad de cómputo. La computadora cuántica presentada por primera vez en 2009 fue una demostración fundamental de su capacidad. No obstante, para obtener capacidades computacionales significativas era necesario aumentar el número de cúbits (la unidad de información básica de la computadora cuántica) y reducir los errores más comunes de los componentes cuánticos. A lo largo de la última década, se han realizado muchas investigaciones sobre diversas aplicaciones prácticas de las computadoras cuánticas, especialmente aquellas basadas en circuitos de materiales superconductores.

La carrera para ser el primero en este campo es feroz, y gigantes tecnológicos como Google, IBM e Intel invierten enormes recursos. A lo largo de los años, se lanzaron computadoras cuánticas con un número creciente de componentes: el récord actual pertenece a Google, que en 2018 anunció un procesador de 72 cúbits. Por otro lado, IBM lanzó una computadora con un procesador de 53 cúbits que estará disponible para los investigadores a través de la nube. Además del número de componentes, es igualmente importante la precisión, y en este frente se han invertido muchos recursos también. En 2019, IBM presentó la primera computadora cuántica comercial, envasada en un cubo de vidrio del tamaño de una habitación. A fecha de hoy, los investigadores y desarrolladores pueden probar a hacer cómputos en procesadores cuánticos a través de Internet, un servicio prestado por varias empresas.

El final de la década también marcó otro hito, cuando Google anunció, en octubre de 2019, que había logrado lo que se conoce como “supremacía cuántica”: una capacidad de cálculo que ni siquiera las mejores supercomputadoras del mundo podrían realizar en un marco de tiempo realista. Es un importante logro y algunos lo consideran el principio de la era de las computadoras cuánticas, al igual que el primer vuelo que en 1904 inauguró el comienzo de la era de los vuelos propulsados. Sin embargo, muchos cuestionaron la declaración, incluidos los rivales de IBM, ya que la supremacía fue alcanzada mediante la resolución de un problema seleccionado especialmente para ese propósito. Sea como fuere, este es un paso importante en el camino hacia capacidades de cálculo inimaginables, y el futuro de este campo parece más prometedor que nunca.

Dr. Dan Yudilevich

Los gigantes tecnológicos están invirtiendo grandes sumas en el campo. Computación cuántica. Ilustración: Science Photo Library

Editores por un momento: avances en la ingeniería genética

La revolución genética, que empezó con el descubrimiento de la estructura del ADN y siguió con la descodificación del código genético y el desarrollo de métodos avanzados para la lectura de su secuencia, reveló la oportunidad de una comprensión más profunda de la vida y del mecanismo genético que la controla. La última década trajo también la revolución de la edición genética: durante años podíamos leer de manera eficiente el código genético, pero editar el genoma, insertar cambios intencionales en la secuencia para reparar mutaciones, silenciar un cierto gen o activar otro, eran tareas difíciles y no siempre precisas. La revolución de CRISPR (Repeticiones Palindrómicas Cortas Agrupadas y Regularmente Espaciadas), un sistema de proteínas presente en las bacterias, ofreció a los científicos la posibilidad de cambiar secciones enteras de ADN a su elección con precisión, eficiencia y a bajo costo.

La revolución que sucede en el mundo de la ingeniería genética no se detiene aquí, sino que influye en muchos otros campos. En la medicina, los investigadores están desarrollando métodos de tratamiento de enfermedades mediante la intervención directa en el genoma del paciente, entre ellas enfermedades genéticas como la anemia falciforme o la diabetes tipo 1, el cáncer, enfermedades infecciosas e incluso la obesidad. La técnica CRISPR se utiliza también para crear polillas que producen seda con proteínas de telaraña, para controlar las poblaciones de mosquitos y un largo etcétera. En la industria alimentaria, el salmón transgénico, que de hecho no fue diseñado mediante CRISPR, fue el primer animal transgénico en obtener la autorización de la FDA, la Agencia de Alimentos y Medicamentos estadounidense. A finales de 2018, un científico chino anunció que había editado el ADN de dos bebés, lo cual desencadenó un escándalo mediático y la exigencia de una supervisión más estricta del sector. Aún es demasiado pronto para saber adónde nos llevará la revolución de la ingeniería genética, pero si la vida es una jungla, al menos tenemos una herramienta que nos permite abrirnos camino en ella.

Ido Kipper

Video del presentador de televisión John Oliver hablando de la ingeniería genética:

Las computadoras que nos sustituirán: inteligencia artificial y macrodatos

El campo de la inteligencia artificial radica en la programación que permite que una computadora se comporte como un ser humano o tome decisiones de manera independiente (por ejemplo, aprendiendo de forma autónoma a través de un proceso llamado aprendizaje profundo o simulando una red neuronal artificial). Este campo ha registrado un desarrollo acelerado en la última década.

Los científicos desarrollaron modelos precisos para pronosticar el clima, y computadoras capaces de conocer su ubicación en función de la visión, crear un audífono selectivo e incluso leer el pensamiento humano. Utilizando grandes bases de datos, las computadoras pueden crear “bulos” (fake news) y hacerse pasar por personas reales o crear imágenes de personas que nunca existieron. La computadora incluso es capaz de ganar la partida a los seres humanos en juegos complejos como el ajedrez, el juego de Go y hasta el póker con muchos jugadores.

En el campo de la robótica, combinando nuevos sensores más precisos con el aprendizaje automático se desarrollaron robots capaces de navegar por sí mismos en entornos desconocidos o identificar situaciones peligrosas mediante una red neuronal artificial.

Los sistemas de aprendizaje son una herramienta importante en la minería de datos a partir de la enorme cantidad de información que generamos cada segundo: desde imágenes y mensajes de texto, pasando por la ubicación y la información médica, hasta información sobre nuestras compras o datos sobre cuándo nuestra impresora necesita un nuevo cartucho de tinta. Si en 2010 generamos 1.2 zettabytes (un zettabyte equivale a 1021 bytes) de datos, en 2019 generamos 4.4 zettabytes, y está previsto que este ritmo vertiginoso continúe aumentando.

A lo largo de la última década, el mayor avance se produjo en el campo de los macrodatos o big data: sistemas que intentan encontrar patrones significativos en cantidades ingentes de datos, utilizando algoritmos avanzados o aprendizaje profundo y con la ayuda de tecnologías que permiten recabar, compartir, almacenar y escanear enormes cantidades de datos. Los científicos ya han empezado a aprovechar estos sistemas para mejorar los diagnósticos médicos, predecir brotes de enfermedades, descubrir nuevas partículas, y, por supuesto, para aplicaciones comerciales. En la próxima década, el análisis de macrodatos se convertirá en una parte fundamental de nuestra vida y, como sucede con cualquier tecnología, habrá quienes la exploten indebidamente.

Amit Shraga

La tasa de producción de datos seguirá aumentando rápidamente, y con ella los métodos de procesamiento. Macrodatos. Foto: Shutterstock

El auge de la inmunoterapia: el sistema inmunitario contra el cáncer

Aprovechar las bondades del sistema inmunitario para luchar contra el cáncer ha sido una de las tendencias más notables en las ciencias biológicas en esta última década. Ya en el siglo XIX había médicos que creían que existía un fuerte vínculo entre el cáncer y las células del sistema inmunitario. En la segunda mitad del siglo XX, los investigadores comprendieron que una de las funciones del sistema inmunitario es destruir las células cancerosas, mediante mecanismos similares a aquellos que se usan para combatir las infecciones virales. Además, comprendieron que algunas de las células cancerosas pueden pasar desapercibidas y no ser detectadas por “el radar” del sistema inmunitario y, por lo tanto, logran prolongar su supervivencia. No obstante, la investigación en este campo no logró avanzar y la mayoría de los adelantos en la investigación del cáncer y el desarrollo de medicamentos para luchar contra él se centraron en la prevención de la multiplicación acelerada de las células cancerosas. Hasta hace una década, la mayoría de los medicamentos contra los tumores sólidos conseguían prolongar la vida de los pacientes tan solo unos meses y se caracterizaban por una rápida regresión de los tumores que más tarde reaparecían adoptando una forma mucho más agresiva.

No obstante, los medicamentos contra los receptores de las células cancerosas, que ayudan a estas a eludir el sistema inmunitario, han cosechado un éxito impresionante al principio de la década del 2010, y por primera vez han prolongado la vida de los pacientes por un periodo de cinco años o más. Al mismo tiempo, se ha desarrollado la tecnología CAR-T, que permite rediseñar una parte de las células del sistema inmunitario de los pacientes para que ataquen a las células cancerosas de una manera más eficaz. Este método fue desarrollado en Israel y la tecnología, que ha protagonizado un exit nada desdeñable, muestra resultados prometedores. Los "padres fundadores" del campo de la inmunoterapia, James Ellison de los Estados Unidos y Tasuku Honju de Japón, recibieron el Premio Nobel de medicina en 2018. Este gran adelanto llevó al desarrollo de cientos de medicamentos experimentales, algunos de los cuales se encuentran en fases avanzadas de ensayos.

Dr. Yochai Wolf

Cómo lucha el sistema inmunológico contra el cáncer? Un video de Nature lo explica:

El mundo está ardiendo: la Tierra continúa calentándose rápidamente

El calentamiento global no avanzó a un ritmo uniforme a lo largo del siglo XX. Desde los años cuarenta hasta los sesenta, el calentamiento se detuvo e incluso hubo un incipiente enfriamiento, pero luego el calentamiento reapareció a un ritmo más rápido. La primera década del siglo XXI trajo nuevas esperanzas, porque el calentamiento disminuyó considerablemente hasta detenerse por completo. Pero esa pausa finalizó en 2014 y desde entonces somos testigos de un ritmo muy acelerado. Esas dos pausas se usan a veces para demostrar que no existe una correlación entre la actividad humana y el calentamiento global: si la cantidad de gases de efecto invernadero de la atmósfera sigue creciendo de manera constante, ¿por qué no aumenta también la temperatura global? La explicación de este fenómeno reside en los ciclos climáticos naturales de la tierra, que provocan variaciones debido a los cambios de las corrientes oceánicas, la actividad volcánica, etc. Cuando a los ciclos naturales se les agrega el calentamiento producido por el aumento de gases de efecto invernadero, puede haber momentos sin calentamiento. De hecho, si la concentración de gases de efecto invernadero no hubiera aumentado al mismo tiempo, habríamos registrado probablemente un enfriamiento considerable y no solo una pausa en el calentamiento global.

Durante la segunda década del siglo XXI renunciamos a la idea de que quizás no somos la causa principal del calentamiento global. Los años 2015-2018 fueron los más calurosos que se registraron desde la revolución industrial (en comparación con el promedio de 1951-1980). El informe del Grupo Intergubernamental de Expertos sobre Cambio Climático (IPCC, por sus siglas en inglés) de 2018 reveló que, si se mantiene la progresión de calentamiento actual, se producirá un aumento de 1,5ºC en comparación con la era preindustrial entre 2030 y 2052, y que, si queremos evitar superar esa cifra y llegar a un punto de sobrecalentamiento, debemos conseguir el objetivo de cero emisiones de gases de efecto invernadero antes del año 2055. En esencia, las emisiones de gases de efecto invernadero han continuado sin cambios, así que el caso hipotético de un aumento de solo 1,5ºC será superado con creces si no tomamos medidas inmediatas para reducirlas.

Jonathan Group

Hemos dejado de pensar que el hombre no es responsable del calentamiento global. Ilustración: Shutterstock

Nuestros subinquilinos: ¿cómo afecta el microbioma a nuestra vida?

La revolución del análisis de secuencias genéticas ha dado lugar a otra revolución: la comprensión de que los huéspedes que viven en nuestro cuerpo afectan a casi todos los aspectos de nuestra vida. Hay al menos 5000 tipos de bacterias en el cuerpo y un número desconocido de hongos, amebas, virus, gusanos, etc. La gran mayoría de ellos viven en nuestro cuerpo de manera habitual y no causan enfermedades, pero sí afectan al apetito, el aumento de peso, la influencia que tienen en nosotros las bebidas dietéticas, la digestión de los lácteos, el desarrollo y el diagnóstico de tumores cancerosos, la eficacia de los medicamentos, el embarazo y la salud del bebe recién nacido, las inflamaciones y muchos otros procesos que se desarrollan dentro de nuestro organismo, tanto en la salud como en la enfermedad. También hay muchos factores que afectan a nuestras bacterias y producen cambios en ellas, desde los antibióticos hasta los vuelos espaciales. Además de la investigación del microbioma de nuestro organismo, es decir, todas las bacterias que viven sobre y dentro del cuerpo, hay estudios que recaban información sobre el microbioma de otros lugares: desde el estómago de una vaca hasta muestras tomadas de la tierra y del mar, y muchos otros lugares.

Dr. Gal Haimovich

La vida que llevamos dentro: un video sobre los microbios que viven en nosotros y su efecto.

Una nueva mirada al universo: las ondas gravitacionales y los neutrinos

En 1916, Albert Einstein presentó su teoría de la relatividad, que describe el comportamiento de las masas, las fuerzas gravitacionales y la dinámica del espacio y del tiempo. Una de las previsiones más sorprendentes fue que la gravedad se mueve como una onda en el espacio. Cuando Einstein propuso esta teoría, pensó que nunca podríamos llegar a medir ese tipo de ondas, porque su efecto en el espacio en el cual vivimos es inferior al movimiento del tamaño de un átomo. Casi un siglo después de la innovadora teoría de Einstein, llegó la prueba de la existencia de dichas ondas: en 2015, por primera vez, se midieron las ondas gravitacionales provocadas por la colisión de dos agujeros negros en una galaxia lejana. Este descubrimiento mereció el Premio Nobel de Física de 2017.

¿Cómo se mide un fenómeno tan débil? El detector LIGO en los Estados Unidos es un interferómetro (dos tubos perpendiculares entre sí, con una longitud de cuatro kilómetros cada uno). Un rayo láser que se divide en dos viaja por cada uno de ellos moviéndose hacia atrás y hacia adelante cientos de veces entre espejos colocados en los extremos de los tubos y, al final, los dos rayos vuelven a encontrarse. Si la onda gravitacional choca contra el detector, alarga ligeramente la trayectoria de uno de los rayos, y lo hace retrasarse una fracción de segundo al llegar al encuentro. Esta diferencia se puede medir con equipos ópticos precisos. LIGO está formado por dos detectores idénticos, instalados uno lejos del otro en los Estados Unidos, y otro detector más pequeño en Europa. La identificación de una onda gravitacional en los tres detectores permite a los físicos calcular la dirección y la distancia de la fuente de las ondas.

Desde que están activos, estos detectores han identificado unas 20 colisiones de agujeros negros y al menos un caso de colisión entre estrellas de neutrones, que también se observó en telescopios ópticos y radiotelescopios. La siguiente fase será planificar un enorme detector de ondas gravitacionales que medirá rayos láser entre satélites en el espacio y podrá detectar las ondas gravitacionales que no se pueden identificar con “pequeños” detectores terrestres que solo miden unos kilómetros.

En la última década, a la identificación de las ondas gravitacionales se le sumó otro tipo de astronomía exótica: los detectores de neutrinos. Estas son partículas evasivas, que casi no reaccionan a nada y son difíciles de identificar. En 2010 se construyó el detector IceCube, compuesto de sensores sumergidos en la profundidad del hielo antártico, y en 2013 se publicaron los primeros resultados de la identificación de partículas del tipo neutrino. La medición del flujo de partículas y la identificación de su fuente ayudan a desarrollar o descartar modelos de explosiones energéticas y generación de rayos cósmicos.

El uso de las ondas gravitacionales y los neutrinos para identificar fenómenos astronómicos amplía considerablemente la caja de herramientas de los astrónomos, que hasta hoy estaba limitada a la medición de la radiación electromagnética, desde la luz visible hasta las ondas de radio y los rayos X. Estas nuevas herramientas permiten recabar nueva información sobre los fenómenos energéticos más exóticos del universo.

Guy Nir

Video por Veritasium que explica el descubrimiento de las ondas gravitatorias:

Las interfaces cerebro-computadora conducen a nuevos tratamientos

Una “interfaz cerebro-máquina” (brain-machine interface) o “interfaz cerebro-computadora” (brain-computer interface) es un dispositivo externo que se “comunica” directamente con el cerebro. En la última década se han registrado grandes avances en el desarrollo de interfaces que estudian los patrones cerebrales al ejecutar un movimiento o planificarlo, a fin de enviar señales a las extremidades de pacientes con lesión de la médula espinal y así eludir la médula espinal dañada que funciona como estación repetidora entre el cerebro y los músculos de los miembros inferiores o superiores.

De esta manera, por ejemplo, las interfaces cerebro-computadora que aprendieron los patrones cerebrales utilizando la imagen por resonancia magnética funcional (IRMf) lograron devolver el movimiento a pacientes con lesiones en la médula espinal. En 2016, utilizando dispositivos que transfieren las señales eléctricas del cerebro se consiguió que pacientes paralizados movieran objetos usando “el poder del pensamiento” y utilizando dispositivos que transfieren la información a las extremidades del cuerpo se consiguió que pacientes paralizados se levantaran de sus sillas de ruedas y volvieran a caminar. Otro uso que tiene la interfaz es restaurar el sentido del tacto en pacientes con extremidades amputadas que usan prótesis y no tienen ningún sentido del tacto en el brazo o la pierna protésica. En personas sanas, el sentido del tacto en las extremidades es fundamental a la hora de retroalimentar el área del cerebro responsable del movimiento para poder ejecutarlo. En 2019, los investigadores anunciaron la restauración del sentido del tacto en una pierna protésica y un brazo protésico. ¿En qué otras direcciones pueden desarrollarse las interfaces? Una de las limitaciones de dichas interfaces es la necesidad de insertar implantes cerebrales, pero recientemente se ha desarrollado una interfaz que aprende los patrones cerebrales sin necesidad de una implantación, y parece que en la próxima década veremos más interfaces de este tipo y quizás interfaces en miniatura que pueden ser llevados de un lugar a otro, con lo cual su uso será más práctico en la vida cotidiana.

Dr. Ido Magen

El vínculo entre el cerebro y las computadoras se estrecha gracias a las tecnologías que se están desarrollando. Manos robóticas tecleando. Ilustración: Science Photo Library

Una gran tecnología gracias a una electrónica miniaturizada

Si tuviéramos que elegir el producto que mejor simboliza la década pasada, elegiríamos el smartphone. Tras llegar el teléfono inteligente a nuestras vidas poco antes del 2010, se convirtió en una parte esencial de la vida moderna, que cambió por completo nuestra manera de comunicar y de consumir información y servicios. Su desarrollo y perfeccionamiento fueron posibles gracias a la miniaturización de los chips electrónicos. Gracias a esta tecnología se puede incluir en un dispositivo del tamaño de la palma de la mano no solamente componentes informáticos, como un procesador y memoria, sino también una pantalla, una cámara y toda una serie de sensores.

La miniaturización electrónica se mide por el tamaño del componente más pequeño, el transistor: a principios de la década de 2010, el récord tecnológico era de 32 nanómetros (0.000000032 metros) y se esperaba que hacia el 2020 estaría disponible una tecnología de 5 nanómetros. La miniaturización de los componentes cumple la Ley de Moore, que establece que el número de transistores de un circuito integrado de alta densidad se duplica en promedio cada dos años. Y, de hecho, la densidad de los componentes se multiplicó por 40, lo cual causó el gran avance de la capacidad de los dispositivos. No obstante, la tecnología actual está forzando los límites de la física: 5 nanómetros es el tamaño de unas decenas de átomos, lo cual expone a los chips a nuevos fenómenos que podrían afectar su fiabilidad. Desafíos como este han dado lugar a la necesidad de probar alternativas a la tecnología actual que permitan mejorar el rendimiento. Una de ellas consiste en sustituir la silicona, el principal componente de los chips, por materiales bidimensionales (láminas con un grosor de apenas unos átomos), que podrían permitir una mayor densidad y flexibilidad mecánica. Otra dirección interesante es la de los circuitos basados en las moléculas biológicas, como el ADN, que también podrían contribuir a la miniaturización.

La miniaturización de los componentes electrónicos fue muy importante en la última década y permitió el desarrollo de otras tecnologías, desde relojes inteligentes y sensores incorporados en la vestimenta, hasta drones y vehículos autónomos, tecnologías que influenciarán nuestras vidas en gran medida en la próxima década.

Dan Yudilevitch

La miniaturización que cambió nuestras vidas. Los teléfonos y relojes inteligentes representan solo la punta del iceberg. Foto: Shutterstock

Las estrellas del espacio exterior: descubrir planetas en otros sistemas solares

Durante muchos años, los científicos se han preguntado hasta qué punto los planetas son un fenómeno frecuente. Hasta 1995, nuestro Sol era la única estrella que sabíamos que tenía planetas, e incluso más adelante, el descubrimiento de planetas en otros sistemas solares era algo excepcional. En 2009 se lanzó el telescopio espacial Kepler, con el fin de encontrar planetas lejanos mediante la identificación de una leve reducción de la intensidad lumínica de una estrella cuando un planeta pasa por delante de ella reduciendo ligeramente la cantidad de luz que llega al telescopio.

Gracias al telescopio Kepler, los investigadores descubrieron más de 4000 planetas nuevos, un descubrimiento que demostró por primera vez que la galaxia está llena de planetas. Los sistemas solares no son algo insólito y, de hecho, el número de planetas es similar al número de estrellas de la galaxia. Kepler descubrió también sistemas en los que los planetas son similares al planeta Tierra, y en algunos casos incluso planetas que se encuentran en la zona de habitabilidad, es decir, a una distancia de su estrella que permitiría la existencia de agua líquida en la superficie del planeta. En los últimos años, se han descubierto planetas alrededor de toda una variedad de estrellas, algunas muy cercanas a nosotros, como enanas rojas o incluso una estrella "muerta" del tipo enana blanca, así como sistemas solares con múltiples planetas.

En la última década, cambió nuestra percepción de los planetas en nuestra galaxia. Hoy en día entendemos mejor cómo se forman los planetas y los sistemas solares y comprendemos que la Tierra no es un fenómeno único en nuestro universo: hay muchos planetas en nuestra galaxia que podrían tener agua líquida. ¿Tendrán también formas de vida? A estas preguntas intentarán responder algunos de los programas lanzados al final de la pasada década: el telescopio espacial TESS, que fue lanzado en 2018, tratará de encontrar planetas alrededor de las estrellas cercanas a la Tierra, y el telescopio CHEOPS, que fue lanzado hace poco, profundizará nuestro conocimiento de ciertos planetas y descubrirá si tienen atmósfera y otras condiciones imprescindibles para la vida, al menos para la vida tal como la conocemos.

Guy Nir

Breve video de National Geographic sobre los planetas de otros sistemas solares:

La última pieza del rompecabezas (por ahora): el descubrimiento de la partícula de Higgs

En las últimas décadas, los físicos descubrieron diversos tipos de partículas subatómicas, y con el tiempo entendieron que todas las partículas y las fuerzas que hay entre ellas, excepto la gravedad, se pueden definir mediante una combinación de 17 partículas elementales. La teoría, que fue denominada el Modelo Estándar, explicaba de manera precisa y casi perfecta todos los fenómenos existentes en el mundo de los átomos.

Según el modelo, las partículas elementales no pueden tener masa por naturaleza. No obstante, en la década de 1960 se propuso un mecanismo por el que adquieren una masa indirectamente: la interacción con un campo escalar. El Campo de Higgs, denominado así en honor de uno de los científicos que concibió la idea, es un campo escalar único porque su valor es distinto a cero, incluso en estado de reposo, sin energía. El Campo de Higgs existe incluso en el vacío y las partículas del Modelo Estándar lo "sienten". La interacción de las partículas con este campo hace que se comporten como si tuvieran masa. En la práctica, no hay ninguna manera de distinguir entre la interacción con el campo y la masa de la partícula en sí, pero el campo se puede encontrar: si se le proporciona suficiente energía, se puede crear una partícula de Higgs que, a diferencia de otras partículas, sí tiene masa. Para encontrarla se necesita un acelerador de partículas especialmente potente, que consiga que algunas partículas lleguen a tener energías muy elevadas.

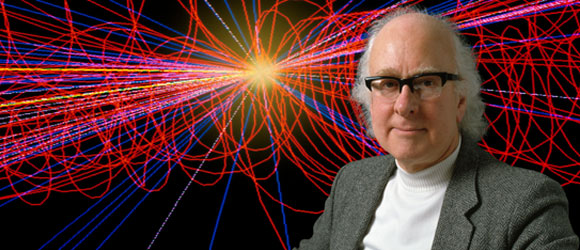

En el gran acelerador de partículas ubicado en Suiza (LHC), se aceleran grupos de protones a una velocidad cercana a la de la luz. Cuando chocan entre sí los dos grupos de protones que se mueven en direcciones opuestas, se emiten miles de millones de partículas. Una serie de detectores mide la cantidad de energía y la dirección en la que se mueven las partículas. La búsqueda de la partícula de Higgs fue un verdadero desafío, ya que la teoría no preveía cuál sería su masa. En 2012, los científicos lograron aislar las características de la partícula de Higgs y descubrieron que su masa es 125 mil millones electronvoltios (133 veces mayor que un protón). El descubrimiento completó el Modelo Estándar, que resume nuestro conocimiento de la materia y las fuerzas que se ejercen en ella, lo que valió a Peter Higgs y a François Englert el Premio Nobel de Física en 2013.

El Modelo Estándar es una buena descripción de la naturaleza, pero no explica algunos fenómenos físicos como la materia oscura y la masa del neutrino (que en teoría no tiene masa). Estos misterios podrían resolverse en esta década.

Guy Nir

Una previsión que tardó casi cinco décadas en ser confirmada. El físico Peter Higgs. Foto: Science Photo Library

Una nueva perspectiva sobre la biología: nuevas tecnologías microscópicas

El microscopio óptico o microscopio de luz ha sido utilizado por los biólogos durante siglos, pero en la última década ha crecido enormemente el uso de la mocroscopía en la investigación biológica. Durante la década anterior ya se registró un gran avance al romper la barrera de la difracción: la capacidad de alcanzar resoluciones inferiores a los 200 nanómetros (la mil millonésima parte de un metro), con el desarrollo del microscopio de súper resolución. En la pasada década, hemos visto nuevos desarrollos como la “claridad”: la capacidad de hacer que cualquier tejido, incluso un ratón completo, sea transparente, y la “microscopía de expansión”, que ofrece la posibilidad de una súper resolución al ampliar el espacio entre las moléculas de la muestra.

Hacia el año 2010, se produjo otro gran avance: la combinación de un microscopio óptico y uno electrónico (CLEM, por sus siglas en inglés). Este método combina la fotografía de muestras biológicas vivas en un microscopio fluorescente, antes de la fijación de las células, para fotografiarlas en un microscopio electrónico. Permite identificar estructuras intracelulares y de moléculas biológicas que no podrían identificarse con el microscopio electrónico únicamente, y permite alcanzar una resolución nanométrica que no era posible ni siquiera con un microscopio de súper resolución. Durante la última década, este método se perfeccionó y los cálculos informatizados permitieron la creación de una imagen tridimensional del interior de una célula con una resolución nanométrica.

La década de 2010 se caracterizó por un mayor desarrollo y uso de tecnologías informáticas innovadoras, como el aprendizaje automático o machine learning y las redes neuronales, para el desarrollo de software capaz de procesar cientos de miles de imágenes microscópicas buscando patrones en dichas imágenes y rescatando información que el cerebro humano nunca hubiera podido encontrar.

Nuevas tecnologías aportan nuevas perspectivas sobre las ciencias de la vida. El microscopio óptico en la investigación biológica. Foto: Science Photo Library

Señales de vida: los mundos de agua del sistema solar

De los ocho planetas de nuestro sistema solar, dos - Júpiter y Saturno - son gigantes gaseosos con numerosos satélites. En los últimos años, los grandes satélites de dichos planetas han estado en el punto de mira de la investigación debido a fenómenos interesantes, como los ríos y lagos de metano líquido sobre la superficie de Titán, el satélite de Saturno, o las fuerzas de la marea que crean actividad tectónica y volcánica en Ío, un satélite de Júpiter. Otros tres satélites, Ganimedes, Europa y Encélado, tienen un enorme océano subterráneo. Estos tres satélites están relativamente distantes del sol, por lo que su superficie está completamente congelada. A pesar de esto, las fuerzas de la marea provocadas por la gravedad del gigante gaseoso calientan el interior de los satélites creando un océano subterráneo cubierto por una capa de hielo que mide decenas de kilómetros de profundidad. Algunos de estos océanos contienen más agua que todos los océanos de la Tierra.

La hipótesis sobre la existencia de los océanos se ha confirmado en la última década gracias a las observaciones y las mediciones de las corrientes de vapor emitidas desde la superficie de estos satélites, entre otros gracias a la nave espacial Cassini, dedicada al estudio de Saturno y sus satélites. Algunas de las observaciones y mediciones mostraron que el agua contiene materiales orgánicos, una posible indicación de la existencia de vida microbiana.

En la próxima década se espera el lanzamiento de dos misiones de investigación a dos satélites de Júpiter, Europa y Ganimedes. La nave espacial europea JUICE y la estadounidense Europa Clipper, tomarán mediciones destinadas a proporcionar más información sobre estos océanos y, quizás, sobre la probabilidad de encontrar pruebas de vida en dichos lugares.

Eran Puss

¿Hay vida en el océano que se encuentra debajo de la capa de hielo exterior? El satélite Encélado en una imagen tomada por la sonda espacial Voyager. Foto: NASA

Cada una de ellas es especial: análisis de células individuales

No todas las células de nuestro cuerpo son idénticas: una neurona es distinta de una célula cutánea y ambas a su vez difieren de las células intestinales. Pero además, en la última década, descubrimos que hay diferencias entre las células del mismo tipo: cada célula se comporta de manera un poco diferente a su vecina. La tecnología microscópica fue la primera en mostrarnos esta circunstancia, pero este campo progresó en los últimos años gracias a la aparición de tecnologías precisas de secuenciación genética que permiten analizar células individuales. Un ejemplo importante es un ensayo publicado en 2011 que indica cómo se desarrolla un tumor mediante la secuenciación de ADN de 200 células tumorales.

Hoy en día, es posible secuenciar el ADN y el ARN de células individuales en experimentos que incluyen miles y miles de células, así como identificar cambios epigenéticos, es decir, cambios relacionados con la activación o silenciamiento de genes mediante moléculas que se unen a ellas, sin cambiar la secuencia del ADN. De esta manera, es posible encontrar diferencias entre células que parecen idénticas, así como descubrir nuevos subtipos de células en un tejido que parece uniforme, e incluso hacer un seguimiento de todas las etapas del desarrollo fetal y estudiar los cambios que ocurren en cada célula. Esta tecnología permitió la iniciativa del proyecto Atlas Celular Humano (Human Cell Atlas, HCA) que realiza una cartografía de todas las células del cuerpo humano y sus características creando un mapa de las células.

Gracias al éxito de las tecnologías de secuenciación genética de células individuales, en los últimos años se hicieron intentos de análisis de proteomas, es decir, la identificación de la composición proteica en células individuales. Estos métodos, junto con métodos de toma de muestras de células individuales y métodos que permiten el análisis de cantidades ínfimas de proteínas, representan el comienzo de la revolución proteómica de las células individuales, que podría culminar en la próxima década.

Dr. Gal Haimovich

Una mejor comprensión de cada célula es esencial para la medicina personalizada. Foto: Science Photo Library

El hombre en busca de sus orígenes: nuevos descubrimientos con respecto a la evolución del hombre

En la última década, la genética ha entrado en el campo de la evolución humana y ha cambiado mucho de lo que creíamos saber. En mayo de 2010 se publicó el genoma del hombre de Neandertal, la secuencia de ADN obtenida de tres huesos de este antepasado del hombre moderno. En el mismo año, los investigadores determinaron la secuencia de ADN proveniente de dos dientes y un hueso de un dedo, que se consideraban neandertales, encontrados en las cuevas de Denisova en Siberia. La secuencia resultante fue lo suficientemente distinta como para que los fósiles fueran considerados como una especie o subpoblación separada: el hombre de Denisova. Más adelante, se encontró un diente y una mandíbula en otra zona, el Tíbet, que pertenecen a esta especie y fueron identificados utilizando el ADN o una secuencia de proteínas.

Los hallazgos genéticos revelaron que nuestros antepasados se encontraron con los neandertales y con los denisovanos después de abandonar África y que procrearon juntos. Hoy en día, todos los seres humanos que no son africanos tienen en su genoma partes provenientes de los neandertales, y ciertas poblaciones de Asia heredaron también el ADN de los denisvanos.

Además, en los últimos diez años se descubrieron nuevas especies de la familia humana de la manera “usual”, es decir, mediante el descubrimiento de fósiles con características únicas. En 2010 fue dado a conocer el Australopithecus sediba, una especie que vivió hace dos millones de años. No lejos de ahí, pero más de un millón y medio de años después, vivió el Homo naledi, descubierto en 2015. Recientemente nos enteramos del descubrimiento de un antiguo homínido encontrado en las Filipinas, el Homo luzonensis, aunque todavía no se ha llegado a un acuerdo con respecto a su clasificación.

En la última década, se produjeron varias revelaciones nuevas sobre la historia más reciente de nuestra especie, el Homo sapiens. La teoría generalmente aceptada era que nuestra especie apareció hace unos 200.000 años, hasta que se descubrieron en Marruecos unos cráneos que parecían casi modernos pero que, en realidad, tenían más de 300.000 años. También encontramos pruebas de que algunos Homo sapiens se desplazaron desde África hacia Israel hace casi 200.000 años y aparentemente llegaron al sur de Europa. Mientras hay investigadores que han tratado de determinar en qué parte de África se encuentra el origen de la evolución de nuestra especie utilizando, entre otros, estudios genéticos, otros sostienen que nuestra evolución no tiene un solo origen, sino que procede de una variedad de poblaciones que se mezclaron entre sí.

Dra. Yonit Aschar

Video del Museo Americano de Historia Natural sobre el origen del hombre: